Du bare metal aux conteneurs : guide du développeur sur les environnements d’exécution

- 5 janvier 2026

- 14 mins de lecture

- Plateforme logicielle

Table des matières

Déjà vécu ce moment redouté du « mais chez moi ça marche ! » ?

Le responsable est souvent une différence subtile dans l’environnement d’exécution — la « scène » où votre code s’exécute. Il peut s’agir d’un binaire lié à la mauvaise glibc, d’une wheel Python compilée pour une autre architecture, ou d’une fonctionnalité du noyau discrètement absente en production. Ces écarts invisibles transforment une build locale réussie en catastrophe au déploiement.

Avoir le bon environnement est crucial pour écrire, tester et livrer des logiciels de manière fiable. Mais le paysage est encombré de termes comme machines virtuelles (VM), conteneurs, environnements virtuels, et bien d’autres. Quelle est la différence, et lequel choisir ?

Nous allons retracer l’évolution de l’environnement d’exécution. Nous partirons du matériel brut, puis passerons par les VM, les conteneurs et les différentes façons d’isoler du code au niveau du système d’exploitation (OS) et du langage. En chemin, nous détaillerons les compromis de chaque approche. À la fin, vous saurez exactement quel outil utiliser pour votre prochain projet.

Le chemin vers une isolation légère

L’histoire de l’informatique est en grande partie celle du partage de ressources sans chaos.

Les premiers systèmes exécutaient une seule charge par machine. Aujourd’hui, un seul serveur peut héberger des milliers d’applications isolées, appartenant à des équipes différentes. L’idée centrale derrière cette évolution est l’isolation : séparer le code, les dépendances et les ressources pour éviter les interférences.

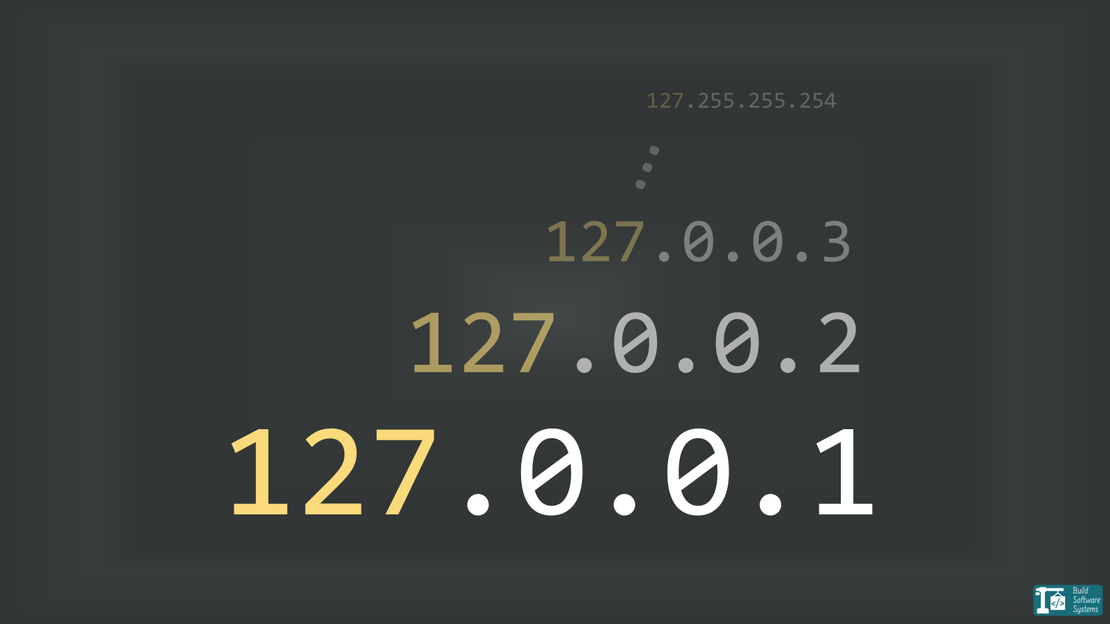

Mais l’isolation n’est pas binaire. Elle existe sur un spectre — matériel, noyau du système d’exploitation, processus, système de fichiers, runtime de langage. Chaque paradigme d’exécution choisit un point différent sur ce spectre.

Règle simple : toute couche située en dessous de votre frontière d’isolation doit déjà être compatible — les conteneurs ne corrigent pas un décalage de noyau, et les environnements virtuels ne corrigent pas une bibliothèque système manquante.

Nous allons du plus lourd au plus léger.

1. Machine physique (Bare metal)

C’est la base. Une machine, un système d’exploitation, votre code qui s’exécute directement sur le matériel.

Matériel (CPU, mémoire, disque, …) : fourni de manière unique par une machine physique. Deux environnements distincts impliquent deux machines physiques distinctes, chacune avec ses propres ressources matérielles dédiées comme le CPU, la mémoire et le disque.

Voyez cela comme une maison individuelle. Toutes les ressources sont pour vous, aucun voisin pour vous déranger.

- Avantages : performances maximales, contrôle total du matériel.

- Inconvénients : coûteux (vous payez les ressources inutilisées), lent à provisionner, peu flexible.

- Cas d’usage : calcul haute performance (HPC), grandes bases de données, ou systèmes legacy nécessitant un accès direct au matériel.

2. Machine virtuelle (VM)

Les VM ont marqué le premier grand bond en efficacité. Un logiciel appelé hyperviseur découpe une machine physique unique en plusieurs machines virtuelles indépendantes.

Système d’exploitation : fourni de manière unique par les machines virtuelles. Deux environnements peuvent s’exécuter sur le même matériel tout en disposant de leur propre OS complet et séparé.

C’est comme un immeuble. Vous avez votre espace privé (cuisine, salle de bain, système d’exploitation), mais vous partagez l’infrastructure sous-jacente (le matériel).

Avantages : isolation forte, possibilité d’exécuter différents OS sur un même hôte (par ex. Windows et Linux).

Inconvénients : surcharge importante (chaque VM embarque un OS complet), démarrage plus lent que les conteneurs.

Outils courants :

- VirtualBox : idéal pour la virtualisation sur poste de travail.

- Hyper-V : l’hyperviseur natif de Microsoft pour Windows.

- KVM : l’hyperviseur de référence sous Linux.

- QEMU : un émulateur et virtualiseur puissant.

- LXD : bien que principalement gestionnaire de conteneurs, les versions récentes gèrent aussi des VM complètes, offrant un outil unifié pour les deux.

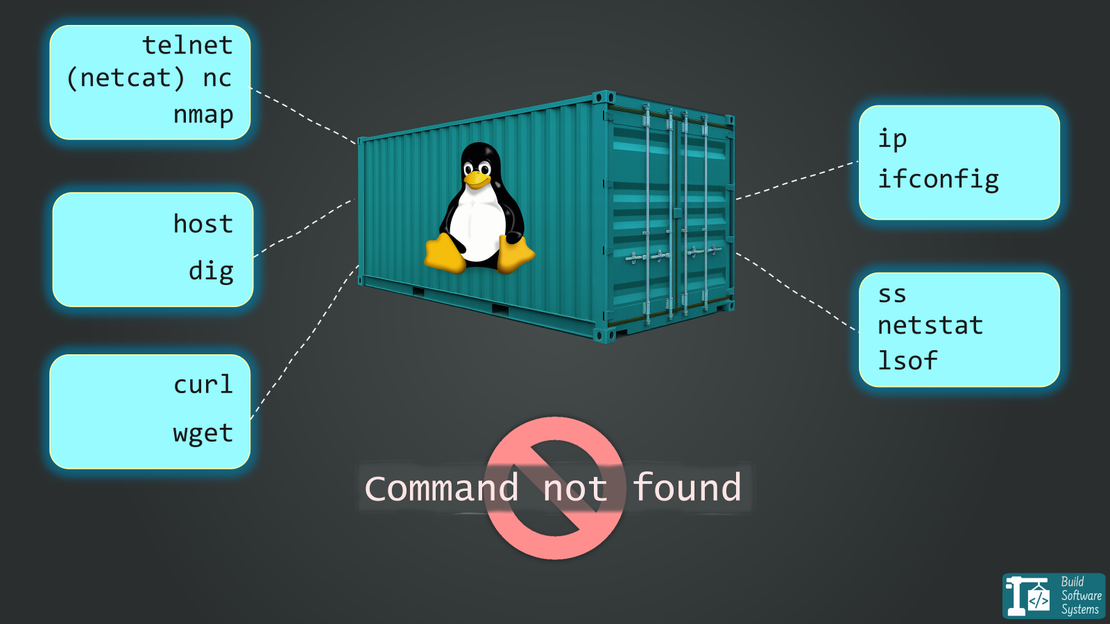

3. Conteneur

Les conteneurs ont transformé le développement logiciel moderne. Ils regroupent une application et ses dépendances, mais — point clé — ils partagent le noyau du système d’exploitation de l’hôte.

Application et dépendances : caractérisées par l’empaquetage d’une application avec toutes ses dépendances. Plusieurs environnements conteneurisés partagent le noyau de l’OS hôte, mais s’exécutent dans des espaces utilisateurs isolés.

Imaginez des chambres d’hôtel. Chacune est une unité autonome et identique, mais toutes s’appuient sur les services centraux de l’hôtel (le noyau de l’OS hôte). Résultat : légèreté et rapidité.

Sous le capot, cette isolation est assurée par les namespaces Linux (qui donnent à chaque conteneur sa propre vue des processus, du réseau et du système de fichiers) et les cgroups (qui contrôlent strictement la consommation de CPU, mémoire et I/O).

Avantages : démarrage extrêmement rapide, faible surcharge, très portable, idéal pour les microservices.

Inconvénients : isolation plus faible que les VM (le noyau partagé peut poser des questions de sécurité).

Outils courants :

Note

La double nature de LXD :

LXD est un outil à part qui brouille volontairement les lignes. Sa force principale est la gestion de conteneurs système LXC, qui ressemblent à des VM ultra-rapides mais restent techniquement des conteneurs.

Cependant, comme indiqué plus haut, LXD peut aussi gérer des machines virtuelles complètes. Il devient ainsi un outil unifié et puissant pour les développeurs souhaitant une interface unique pour les deux types d’environnements.

Gérer beaucoup de conteneurs ? L’orchestration

Des outils comme Docker et LXD sont parfaits pour exécuter des conteneurs sur une seule machine. Docker Compose va plus loin en gérant des applications multi-conteneurs comme une seule unité. Il permet de définir ensemble des services comme un serveur web et une base de données, tout en restant sur un hôte unique.

Quand il faut gérer des applications sur plusieurs machines, on passe aux orchestrateurs de conteneurs comme Kubernetes, Docker Swarm ou Nomad. L’orchestration n’est pas de l’isolation. C’est une couche supérieure de gestion pour l’ordonnancement, la montée en charge et le réseau à grande échelle. Elle ne résout ni la dérive d’environnement, ni les conflits de dépendances, ni la reproductibilité des builds.

Même si l’orchestration mérite un article à part entière, c’est l’étape logique après l’adoption des conteneurs.

4. Bac à sable (Sandbox) de processus

C’est une forme d’isolation plus spécialisée, souvent utilisée pour la sécurité. Elle « met en prison » un processus en restreignant sa vision des ressources système.

Isolation au niveau de l’interface : définie par le filtrage des interactions d’un processus avec le noyau Linux. Plutôt que de fournir un nouvel environnement, on retire au processus une partie de ses « pouvoirs » et on limite son autorité et son vocabulaire. Cela crée un espace d’exécution cloisonné pour un processus unique ou un groupe de processus liés.

C’est comme placer une activité précise dans une « armoire de sécurité ». On ne construit pas une nouvelle pièce ; on limite simplement ce que le processus peut faire dans le système existant, derrière une vitre épaisse et avec des gants lourds.

- Avantages : très léger, fonctionnalité de sécurité native à l’OS.

- Inconvénients : configuration délicate, moins riche qu’un runtime de conteneurs complet.

Les sandboxes excellent quand on veut réduire le rayon d’impact d’un processus — pas quand on cherche un environnement reproductible. Il s’agit de limiter les dégâts, pas de standardiser l’exécution.

Pour construire un vrai bac à sable, on contrôle trois dimensions précises :

- Où (Système de fichiers) : limiter l’accès à certains dossiers.

- Quoi (Privilèges) : limiter l’autorité à des actions spécifiques.

- Comment (Appels système) : limiter la communication avec le noyau du système.

La boîte à outils et les mécanismes de sandboxing

On peut combiner les mécanismes suivants (pour un sandbox robuste), ou les utiliser séparément :

Prisons de système de fichiers (Où) : restreignent le processus à une arborescence donnée.

Séparateurs de privilèges (Quoi) : découpent les pouvoirs « root » en petites unités. Au lieu de donner tous les droits, on n’accorde que le strict nécessaire (comme

CAP_NET_BIND_SERVICEpour ouvrir un port).- libcap : gère les capabilités Linux. Plutôt qu’un choix binaire « root vs utilisateur », il découpe les pouvoirs en plus de 40 bits granulaires (par ex.

CAP_NET_ADMINpour gérer le réseau sans pouvoir lire les fichiers de tout le monde). - setcap / getcap : utilitaires en ligne de commande pour attribuer ces pouvoirs précis aux processus.

- libcap : gère les capabilités Linux. Plutôt qu’un choix binaire « root vs utilisateur », il découpe les pouvoirs en plus de 40 bits granulaires (par ex.

Filtrage des appels système (Comment) : un pare-feu pour le noyau. Il empêche l’exécution d’appels dangereux (comme reboot ou ptrace), même avec des privilèges root.

- seccomp : fonctionnalité du noyau Linux qui filtre les appels système. Par exemple, si un processus tente un appel non autorisé (comme

execvepour lancer un shell), le noyau le termine immédiatement.

- seccomp : fonctionnalité du noyau Linux qui filtre les appels système. Par exemple, si un processus tente un appel non autorisé (comme

bubblewrap et Firejail sont des « wrappers » de haut niveau qui combinent tout cela. Ce sont les moteurs derrière des applications modernes « sandboxées » comme les Flatpaks.

Info

Même si ces outils offrent une isolation « chirurgicale » pour des processus individuels, ce sont aussi les technologies principales que les conteneurs (comme Docker) automatisent et regroupent dans un package unique et portable.

5. Environnement virtuel

C’est probablement l’isolation que vous utilisez au quotidien en tant que développeur. Elle n’isole ni l’OS ni le matériel, mais les dépendances d’un langage de programmation.

Espace de travail spécifique au langage : centré sur l’isolation des dépendances d’un langage donné. Cela permet à plusieurs projets sur une même machine d’utiliser des versions différentes d’un même langage et de bibliothèques sans conflit.

C’est votre organiseur d’atelier. Un projet nécessite une ancienne version d’une bibliothèque, un autre la dernière. L’environnement virtuel range leurs outils (dépendances) dans des tiroirs séparés et étiquetés. Cela évite l’« enfer des dépendances ».

- Avantages : indispensable pour gérer les dépendances de projet, simple d’usage, orienté développeur, zéro surcharge de performance.

- Inconvénients : aucune isolation au niveau de l’OS ou de la sécurité ; le code a toujours accès à vos fichiers utilisateur, au réseau et au matériel.

Limite clé à garder en tête : les environnements virtuels résolvent les conflits de dépendances, pas la compatibilité système.

Si votre code dépend d’une version précise de libc, d’un paquet OS, d’une fonctionnalité du noyau ou d’un binaire externe, un simple venv ne suffit plus.

Tip

Heuristique directe : si votre build ou votre runtime dépend de l’état du système ambiant que vous ne contrôlez pas explicitement — bibliothèques système, paquets OS, fonctionnalités du noyau — un environnement virtuel est déjà trop faible.

Comment fonctionne l’isolation moderne

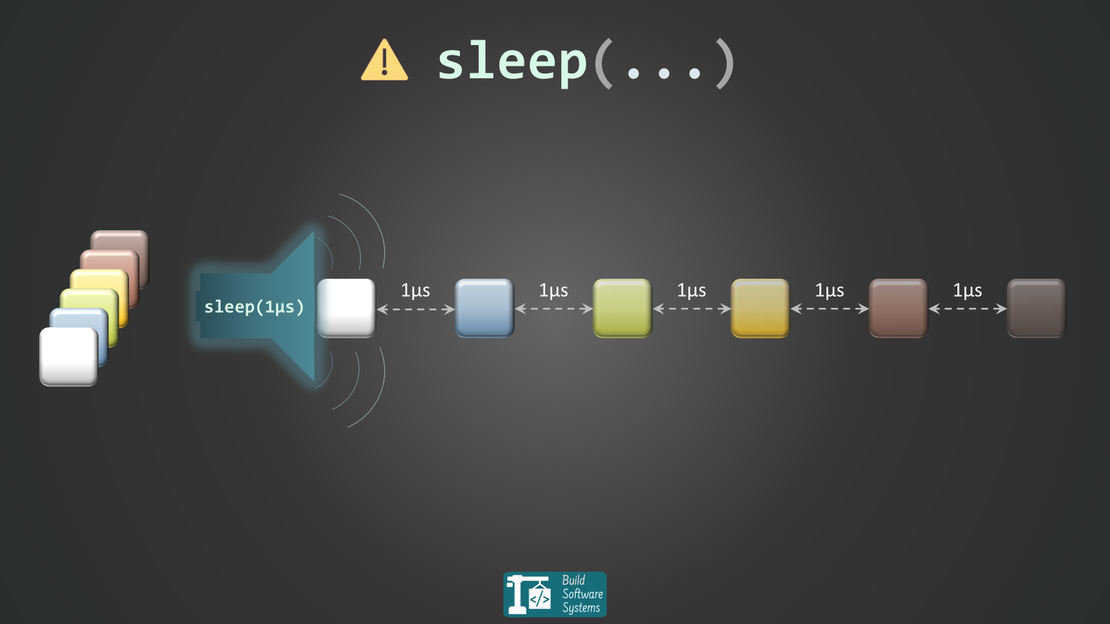

Pour construire un espace de travail propre, il faut résoudre trois problèmes. Historiquement, un outil par problème. Les toolchains unifiées modernes les fusionnent.

Le runtime (gestionnaires de runtime) : Ces outils gèrent la version du langage. Ils permettent d’exécuter Python 3.8 pour un projet legacy tout en utilisant Python 3.14 pour un nouveau.

Exemples :pyenv(Python),nvmoufnm(Node.js),rustup(Rust),goenv(Go).L’environnement (isolation du PATH) : Indique au système où chercher les bibliothèques. En Python,

venvouvirtualenvcréent un dossier pour stocker les libs. En Node.js et Rust, c’est implicite vianode_modules/ou un répertoire de build spécifique (target/) relatif au projet.Les dépendances (gestion des paquets) : Téléchargent et gèrent les versions exactes des bibliothèques nécessaires à l’exécution.

Exemples :pip(Python),npm(Node.js),cargo(Rust),go mod(Go).

La montée des outils « tout-en-un »

La tendance actuelle est l’abandon d’outils fragmentés au profit de toolchains contextuelles. Elles détectent la configuration du projet et alignent automatiquement runtime, environnement et dépendances.

uv(Python) : un binaire unique extrêmement rapide qui remplacepyenv,venvetpip. Il installe les versions de Python et gère les bibliothèques en une seule étape.Conda(Data Science) : un gestionnaire lourd qui gère versions de langage, bibliothèques et même des dépendances système comme des compilateurs C++ ou des pilotes GPU.Rustup+Cargo(Rust) : la référence en matière d’intégration. Techniquement deux outils, mais pensés comme un tout. On peut utilisercargo +nightly buildpour changer de compilateur à la volée, ou un fichierrust-toolchain.tomlpour figer la version pour toute l’équipe.

Combiner les environnements : le meilleur des mondes

Point clé : ces environnements ne s’excluent pas. Ils sont souvent empilés pour créer des workflows solides et professionnels.

Un setup courant ressemble à ceci :

- On commence par une machine virtuelle chez un fournisseur cloud comme AWS ou Google Cloud.

- Sur cette VM, on installe Docker pour gérer des conteneurs.

- Dans un conteneur, l’application s’exécute avec un environnement virtuel spécifique au langage (comme

venven Python) pour les dépendances.

Cette approche en couches offre l’isolation matérielle de la VM, l’empaquetage des conteneurs et une gestion propre des dépendances.

Bulletin d'information

Abonnez-vous à notre bulletin d'information et restez informé(e).

Le futur : abstraction sans perdre le modèle mental

La direction est claire : les environnements d’exécution deviennent plus abstraits — mais pas plus simples.

Chaque nouveau paradigme retire une responsabilité au développeur tout en plaçant la frontière d’isolation plus haut. Les compromis ne disparaissent pas ; ils se déplacent.

Les conteneurs comme interface par défaut

Les conteneurs sont devenus l’unité d’exécution standard. Des outils comme les Dev Containers formalisent cette approche en plaçant l’environnement de développement lui-même dans un conteneur.

Ici, la frontière d’isolation se situe clairement à l’interface du noyau de l’OS. Le noyau est partagé, mais tout ce qui est au-dessus — système de fichiers, dépendances, outils — est verrouillé et reproductible.

Cependant, cette frontière fuit encore. Des conteneurs conçus pour cgroups v2 ou des syscalls spécifiques échoueront sur des hôtes plus anciens. Quand le conteneur suppose des fonctionnalités du noyau absentes, l’échec est souvent silencieux ou catastrophique.

Dans ces cas, l’abstraction du conteneur « universel » se brise : on n’exécute pas seulement une image ; on reste lié au matériel et au noyau sous-jacents.

Serverless : fixer la frontière au niveau de la fonction

Les plateformes serverless placent la frontière encore plus haut. On ne gère plus machines, OS ni même conteneurs directement. On fournit une fonction et on accepte un contrat d’exécution très contraint.

En pratique, cette abstraction repose toujours sur des mécanismes d’isolation spécifiques. On peut citer par exemple Firecracker, qui s’appuie sur des machines virtuelles légères, ou encore les isolats V8, qui exécutent le code au sein de runtimes de langage strictement contrôlés.

C’est puissant, mais prescriptif : cold starts, limites de temps d’exécution et accès système restreint ne sont pas accidentels — c’est le prix de l’abstraction. Le serverless est idéal quand on peut vivre entièrement dans ce contrat, et pénible sinon.

WebAssembly (Wasm) : une nouvelle primitive d’isolation

Wasm est intéressant non pas parce qu’il remplace les conteneurs, mais parce qu’il introduit une nouvelle frontière. Au lieu d’isoler au niveau du noyau ou du processus, Wasm sandboxe l’exécution au niveau des instructions et des capacités.

Résultat : un runtime portable et sécurisé, cohérent sur navigateurs, serveurs et environnements edge. Si les conteneurs ont standardisé la façon d’empaqueter les logiciels, Wasm tente de standardiser la façon dont les logiciels s’exécutent.

Le fil conducteur est simple : le progrès n’élimine pas l’isolation — il la choisit plus consciemment.

Conclusion

Chaque environnement d’exécution est un compromis entre contrôle, isolation, performance et confort. Les problèmes apparaissent quand on traite ces outils comme interchangeables — ou pire, quand on les utilise sans comprendre ce qu’ils isolent et ce qu’ils n’isolent pas.

En cas de doute, posez une seule question : quelle est la couche la plus basse qui doit être identique pour que ce code se comporte correctement ? Matériel, noyau, paquets OS, ou seulement les dépendances du langage. La réponse indique directement le bon environnement d’exécution.

Comme avec les conteneurs et les sandboxes de processus, choisir la mauvaise frontière ne mène pas à un échec propre. On obtient des pannes subtiles, sensibles côté sécurité, ou douloureusement difficiles à diagnostiquer.

Raccourcis de décision pratiques :

- Utilisez un environnement virtuel quand seules les dépendances du langage varient.

- Utilisez un conteneur quand les bibliothèques système, l’outillage ou les hypothèses d’exécution doivent être identiques.

- Utilisez une VM quand le comportement du noyau, les politiques de l’OS ou les frontières de sécurité ne doivent pas être partagés.

Une fois les environnements d’exécution vus comme des abstractions en couches plutôt que comme des produits concurrents, les décisions d’architecture deviennent plus claires — et le « chez moi ça marche » devient un souvenir.

C’est pourquoi confondre l’isolation au niveau du langage (comme venv) avec l’isolation au niveau de l’OS (conteneurs ou sandboxes) coûte si cher : elles se situent à des points totalement différents du spectre d’isolation et échouent de manière fondamentalement différente.

Si vous êtes prêt à passer à la pratique avec Docker, vous pouvez explorer comment fusionner vos environnements de développement et de production dans un seul Dockerfile pour éliminer toute dérive.

Si vous souhaitez être averti lorsque je publie des articles comme celui-ci, vous pouvez vous abonner par e-mail.